In Michel Serres’ 1989 erstmals erschienenen Elementen einer Geschichte der Wissenschaften steht der Computer am Ende einer Vielzahl von Verzweigungen im Netz aller möglichen Wissens- und Wissenschaftsgeschichten. Seine Bedingung liegt dabei nicht nur in allen Netzwerken, die ihm vorausgehen. Serres lässt keinen Zweifel daran, dass der Computer zu jenen Maschinen gehört, die man Universalwerkzeuge nennt – „da sie vom Werkzeug die Effizienz und vom Universellen die Wissenschaftlichkeit geerbt haben“.[1] So weit, so vertraut, könnte man mit etwas zu viel Gewissheit meinen: Rechenmaschinen sind eben spätestens seit Turings tape als universelle Maschinen konzipiert worden. Aber bereits Serres stellt nicht die Philosophie und Mathematik des Rechnens mit symbolischen Maschinen in den Vordergrund: Weder Leibniz und Pascal, noch Turing und von Neumann hätten die Rechenwerke komplett im Kopf gehabt, bevor sie sich ihrer konkreten Realisierung widmeten. Im Gegenteil hält Serres hier die praktische Realisierung des Digitalrechners durch Forschung hoch:

„Wer forscht, weiß nicht, sondern tastet sich vorwärts, bastelt, zögert, hält seine Entscheidungen in der Schwebe. Nein, er konstruiert den Rechner von übermorgen nicht dreißig Jahre vor seiner Realisierung, weil er ihn nicht voraussieht; während wir, die ihn kennen und fortan benutzen, leicht dem Fehlschluß erliegen, er hätte ihn vorausgesehen. In Wirklichkeit ist es mit ihm wie mit allen Akteuren dieses Buches – den individuellen und den kollektiven, den materiellen wie den intellektuellen: sie sind nur Darsteller seiner Verzweigungen und seines schwankenden Netzes.“[2]

Pierre Levys im selben Band publizierter Artikel zur Erfindung des Computers, den Serres mit dieser Wendung anmoderierte, versuchte diesen hohen Wetteinsatz zumindest in Teilen einzulösen. So benennt bereits Levy, dass etwa John von Neumann massiv von der gemeinschaftlichen Arbeit an der Moore School of Electrial Engineering der University of Pennsylvenia profitierte, und hier vor allem von John Eckert und John Presper Mauchly. Anstelle heroischer Erfindungsgeschichten steht hier die Umnutzung heterogener Materialien und Ideen, die für die Zwecke des eigenen Unternehmens genutzt und gekapert werden. Wenn Charles Babbage oder John von Neumann hier ihren Auftritt haben, dann nicht als Heroen, sondern als Teil weiterer Praxisgemeinschaften und -formationen.

Von einer Mediengeschichte der Praxisgemeinschaften des Computings und seiner hidden figures war Levy damit nicht mehr weit entfernt. Mitunter stellen darin ingenieurstechnische Problemlösungen die wichtigere Ressource bereit als epistemologische Genauigkeit: „Wie wir zeigen werden, mag die Frage der Geschwindigkeit oder der Dauer von Operationen unter logischem Gesichtspunkt irrelevant sein, wird aber entscheidend, wenn es darum geht, tatsächlich eine universal verwendbare, programmierbare Rechenmaschine zu konstruieren.“[3] Computer sind hier schlicht keine universellen Maschinen, sondern Objekte, deren universelle Verwendbarkeit immer herstellungs- und begründungsbedürftig bleibt. Sie fluktuieren ebenso wie die wissenschaftshistorischen Netze, deren Stabilität die Elemente einer Geschichte der Wissenschaften immer wieder infrage stellen. Gerade die frühen Computer sind Objekte, die auf eine sehr spezifische Weise in eine bestimmte Vorstellungswelt, „ein bestimmtes soziales und technisches Universum“[4] eingelassen bleiben.

Serres und Levy ist es im Rahmen einer Wissenschaftsgeschichtsschreibung gelungen, die Heterogonie der technischen Zwecke des Rechnens in den Vordergrund zu stellen. Die Universalisierung des Computers aus seinen kooperativen Praktiken heraus ist und bleibt seitdem das eigentlich zu Erklärende. Wie aber soll man sie begründen, ohne dabei die komplexen mathematikhistorischen, aber auch physikalischen Voraussetzungen des digitalen Rechnens aus dem Blick zu verlieren? Mit Serres kann man von einer fortgesetzten Vorläufigkeit der sozio- und kulturtechnischen Netzwerkformierungen ausgehen. Ich habe tatsächlich immer gezweifelt, wenn das Computing dem Networking vorgeordnet wurde, und die Apparate von ihren Praktiken getrennt wurden. Tatsächlich sind Vernetzen und Rechnen ko-konstitutiv, und das verteilte Rechnen schon seit der mesopotamischen Tempelwirtschaft und antiker Himmelsbeobachtung nicht die Ausnahme, sondern die Regel. Differenzen entstehen dadurch, welchen Praxisgemeinschaften der Zugang, die ökonomischen Ressourcen und lehr- und lernbaren skills zur Etablierung ihrer jeweiligen Zwecke zur Verfügung stehen.

Wer Universalisierungen verstehen will, muss deshalb Spezialisierungen folgen, mit denen eine Technik gekapert und umgewidmet wird. Denn die strukturelle Offenheit des digitalen Rechnens macht die Medialität des Computers aus. Erst durch die spezialisierte und individualisierte Aneignung entsteht das „Medium aus der Maschine“, wie es die es Informatikerin Heidi Schelhowe einmal treffend gesagt hat. Das gilt für die frühe History of Computing, die staatliche, korporative und wissenschaftliche Akteure privilegierte, ebenso wie für den Aufstieg des Personal Computings, des World Wide Webs, der Open-Source-Kulturen und mobiler, smartphone-basierter Netzwerke.

Why has (personal) computing given way to (planetary) computation?

Die konstitutive Offenheit des digitalen Rechnens und seine Medienpraxisspezifik haben dabei die Ausprägung neuer Machtformationen nicht verhindert, sondern im Gegenteil begünstigt. Gerade rezente Entwicklungen wie Big Data, Plattformökonomien, Internet der Dinge und die neue Geopolitik des maschinellen Lernens zeigen, dass es sich beim digital vernetzten Computer um eine einstmals im 20. Jahrhundert universalisierte Maschine handelt. Aber nur weil sich Computer jetzt überall und nirgends befinden, heißt dies nicht, dass man von postdigitalen Verhältnissen ausgehen sollte. Vielmehr haben Zweckentfremdungen des digitalen Rechnens innerhalb weniger Jahre eine beispiellose Schließung herbeigeführt, in der Big Tech und staatliche Agenturen ihre Spezialisierungen zum Maßstab aller Datenpraxis gemacht haben. Ja, digitale Rechner sind und bleiben proteische Maschinen. Aber im 21. Jahrhundert steht ihre prometheische Kraft immer weniger Individuen zur Verfügung, die gegenüber der konzentrierten agency neuer Medienagenturen und staatlichem Handeln ins Hintertreffen geraten sind. Wie konnte dies passieren?

Nachdem die Welt „in den Computer gekommen ist“ – um eine Formulierung von Michael Mahoney aufzugreifen, die jüngst David Gugerli weitergedacht hat[5] –, ist sie nicht notwendig eine bessere geworden. Damit möchte ich keineswegs einer vermeintlich besseren, früheren Welt, in der die kooperative wechselseitige Konstitution von Praxisgemeinschaften noch geholfen hat, das Wort reden. Dennoch ist die kurze Zeit nach 1989, in der eine beispiellose Entfaltung vergleichsweise offener und freier cultures of computing[6] in rekursiven Öffentlichkeiten stattfand, mittlerweile zum Zwischenspiel der Mediengeschichte geworden. Warum ist dies der Fall? Mein Verdacht richtet sich dabei auf das lange Zeit erfolgreich als Mitmachmedium getarnte Web 2.0, mit dem seit etwa 2005 alle Öffentlichkeiten zu Datenöffentlichkeiten geworden sind. Das programmierbare Web harrt weitestgehend noch der illusionslosen und agnostischen Rekonstruktion. Es war wohl eher Mitwach- als Mitmachmedium. Seine Proliferation hat nicht nur zur Entstehung von Blogosphäre und Social-Media-Plattformen geführt. Wir verdanken dem sogenannten Web 2.0 die bis heute maßgebliche Datenorientierung digitaler Medienpraxis, die mit dem Euphemismus der „Hintergrundkooperation“ nur unzureichend beschrieben ist.

Eigentlich wollte ich diesen Text durch einige historisch folgenreiche Fälle von Spezialisierungen hindurch erzählen, mit denen die Wechselspiele zwischen Universalisierung und Spezialisierung besser verständlich werden. Auf meiner Liste standen die Standardisierung des digitalen Bezahlens anhand der Kreditkarte und ihrer mittelfristigen Folgen (1971ff.), Jonathan Sternes brillante Rekonstruktion der Entstehung des MP3-Formats (1987f.), der beispiellose Erfolg des World Wide Webs als öffentlichem Medium (1989ff.) samt seiner schwerwiegenden Transformation durch das Web 2.0 und mobile Nutzungsweisen (2005f.). Nicht alles kann in einem kurzen Blogpost gleichrangig behandelt werden, aber trotzdem bleibt die Frage: Was haben deren medienhistorische Trajektorien miteinander gemeinsam? Und was wäre ihre gemeinsame medientheoretische Formel?

Die Spezialisierungen gehen der Universalisierung voraus.

Die amerikanische Kreditkarte wurde vor ihrer ab 1971 kodifizierten Standardisierung in zahlreichen Praktiken und Formaten genutzt. Kaufhäuser akzeptierten seit den 1920er Jahren charge-a-plates und charge coins mit integrierten Kundendaten. Der als exklusiv vermarktete Diners Club verwendete in den 1950er Jahren Papierhefte und Pappkarten für seine Identifikationskarten. Für die seit 1959 eingesetzten Plastikkarten wurden erst spezialisierte Prägemaschinen, bald auch softwarebasierte Großrechner-Anbindungen zur effizienteren Herstellung verwendet. Dem Status als special-purpose money entsprachen die spezialisierten Infrastrukturen und die wilden Praktiken der Markteroberung mit Massenmailings einerseits und Umnutzung durch Betrugs- und Fälschungspraktiken andererseits. Die Spezialisierungen konnten sich dabei aber auf den universalisierten Wertmaßstab des US-Dollars ebenso verlassen wie die tiefe Einbettung der Kreditwürdigkeit in der Finanzmedienkultur der Vereinigten Staaten.

Wenn also das erste Standardisierungsdokument des American National Standards Institute von 1971 festhält „The purpose of this standard is to achieve uniformity of credit-card specifications“[7], dann geht es um nicht weniger als die Schaffung eines neuen immutable mobile, das Kredit- und Zahlungspraktiken exakt ein Format gibt. Die Universalisierung als ‚bewegliche Fixierung‘ war aber damit noch kein durchgesetzter fait social des US-amerikanischen Kapitalismus, trotz dessen konsumistischer und kreditorientierter sozialer Dispositionen. Erst mit den weiteren Standardisierungsschritten 1973, 1976 und 1983, der Aufnahme in internationale Standards der ISO, und vor allem dem in den 1980er Jahren folgenden Aufstieg von Visa und MasterCard als globalen Unternehmen, lässt sich von einer praktischen Universalisierung sprechen. Sie realisierte eine bis in die Gegenwart reichende Aufteilung digitaler Bezahlmärkte, die erst in den letzten zehn Jahren durch Apps – die wiederum die Medialität der Kreditkarte in Software übersetzen,– und Kryptowährungen infrage gestellt worden ist.

Formate fixieren Digitalität (et vice versa).

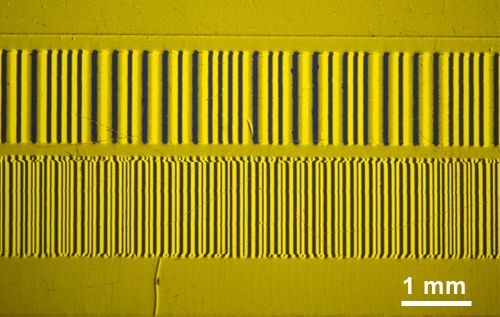

Das offene Geheimnis der Kreditkartenstandardisierung lag in ihrer Realisierung computertechnischer Maschinenlesbarkeit, mit der eine neue Intensität des Registrierens, Identifizierens und Klassifizierens möglich wurde. Zur Universalisierung gehörte der Magnetstreifen, ab Mitte der 1990er Jahre sukzessive durch Chips ergänzt, unauflöslich mit dazu. Man kann sogar sagen, dass durch den geringen Speicherplatz, den ein Streifen für persönliche Daten wie Name und Kontonummer bot, eine ganze weitere Ökologie spezialisierten Computings entstehen musste. IBM hatte genau darauf strategisch gesetzt: Je simpler die Kartendigitalisierung, umso smarter mussten die von Big Blue angebotenen Großrechner sein. So führte die Fixierung der wenigen unverschlüsselt gespeicherten persönlichen Daten, die neben den Banken noch die Fluglinieninteressen bediente, zu einer Fixierung von Digitalität – zugunsten eindeutiger personaler Identifikation. Das ist auch deshalb bemerkenswert, weil digitale Daten sich insbesondere durch das auszeichnen, was man „interchangeability of representations“ nennen kann: Repräsentationsweisen können ständig neu berechnet und recodiert werden. Die auf Plastik wie Magnetstreifen festgehaltenen Daten sind aber gerade darauf ausgelegt, fixer Teil einer Kette von Datenverarbeitungen und möglicher Übersetzungen zu sein.

Es würde zu kurz greifen, diese Fixierung zugunsten der Beweglichkeit lediglich als eine historische bedingte Merkwürdigkeit aus der Frühzeit des finanzindustriellen Computings zu verstehen. Denn obwohl die Übersetz-, Kopier- und Konvertierbarkeit von Daten nachgerade die Bedingung digitaler Praxis darstellt – und zugleich das Digitalwerden von Praxis als Anhäufung von data points[8] –, sind es Fixierungen, Stabilisierungen und Universalisierungen von Digitalität, an denen sich die medientheoretisch wichtigsten Punkte festmachen lassen. Je weiter diese Stabilisierung geht, umso eher generiert sie wiederum modulare Strukturen.

Immutability oder Nicht-Reproduzierbarkeit kennzeichnet digitale Medienkulturen mehr, als wir uns gemeinhin eingestehen. Wie sonst sollte man verstehen, warum das PDF-Format Daten fixiert und Dokumente bürokratisiert? Papierförmige immutable mobiles sind selten geworden. Formate und Infrastrukturen, die Digitalität fixieren und in modulare Ordnungen bringen, haben hingegen Konjunktur. Das gilt nicht nur für die Einbettung von Copyrights, sondern auch und gerade für digitales Geld, das im keystroke capitalism immer nur einen Datenbank- bzw. Tabelleneintrag darstellt, dessen Beträge nicht einfach verdoppelt oder kopiert werden können, ohne die symbolische Ordnung des Kapitalismus zu gefährden.

Jonathan Sterne hat auf einem anderen Feld gezeigt, wie mit der Standardisierung des MP3-Formats zwar wissenschaftliche Universalisierungsansprüche scheiterten, aber eine – so vom standardisierenden Gremium nicht erwartete und beabsichtigte – praktische soziale Ubiquität ermöglicht wurde. Mithilfe professioneller Tests, mit denen die optimale psychoakustische Kompression des digitalen Tons ermittelt werden sollte, zielte das standardisierende MPEG-Konsortium 1990 und 1991 auf eine potenziell universelle Reichweite des besten Algorithmus. Tatsächlich erwiesen sich die Tests nicht nur als öffentliche Performance, sondern als proving ground für einen partikularen Universalismus der beteiligten Hörexperten. Schon die Listen der für die Codierung genutzten Musikstücke – von Suzanne Vegas Tom’s Diner über „male speech“ bis zu einem Trompetenkonzert Joseph Haydns – verweisen auf die spezifischen kulturellen Dispositionen der Hör- und Codiertests, die auf ‚legitimer‘ und bereits bekannter Musik beruhten.

Sterne diagnostiziert sogar einen anfänglichen, kantianischen Universalitätsanspruch gegenüber den Audioaufnahmen: „Everything in the listening-test scenario was designed to facilitate this kind of disinterested, reflective judgment, in the service of producing a “universally communicable” sonic format through that (expert, SG) judgment.“[9] Diese Ambition, ein gut klingendes, realistisch wirkendes Hörerlebnis aus interesselosen Wohlgefallen heraus zu ermöglichen, scheiterte aber. Die meiste Forschung widmete sich bspw. Tonhöhen und Timbre, nicht aber dem Rhythmus. Zudem bestanden zwischen den angenommenen Anwendungsfeldern, die nicht nur instrumentelle Musikaufnahmen, sondern auch Sprachtelefonie und Radiosprache umfassten, unterschiedliche Praxiskonventionen. Für Telefonie und Radio wurden Geräusche nah am Mikrofon aufgenommen, für Instrumentalton im Raum platziert. Aus dem strategischen Universalismus wurde Schritt für Schritt ein Partikularismus, in dem kultureller bias, interne Widersprüche und politische Implikationen offensichtlich wurden.

MP3-Dateien mögen zwar, vermittelt durch Piraterie, den Aufstieg des WWW und andere Zufälle, seit Mitte der 1990er Jahre sozial ubiquitär geworden sein. Aber ihre praktische Allgegenwart verdeckt, dass sie sich als spezialisierte Affordanz durchsetzen konnten: „The MP3 format is designed for casual users, to be heard in earphones in trains or on the tiny speakers of a computer desktop, to be aggregated in blogs, to be carried around in large volume on portable audio players, to be sent in e-mails and IMs and through file-sharing programs. This is not all music for all time, but it speaks to the condition of music in contemporary life in many places around the globe.“[10]

Auf Universalisierung folgen neue Spezialisierungen.

Sowohl die Kreditkarte als auch das MP3-Format sind durch vergleichsweise kleine Praxisgemeinschaften in industriellen Konsortien standardisiert worden. In beiden Fällen kann an den ökonomisch motivierten Interessen der beteiligten Akteure kein Zweifel bestehen. Auf die private Entwicklung sollte die kommerziell getragene öffentliche Nutzung folgen. Für beide Medientechniken sollte das Einsatzgebiet aufgrund des universellen Geltungsanspruch so weit wie möglich reichen: Globale Formate formatieren ihre Globalisierungen, die wiederum spezielle Einsatzzwecke hervorbringen wie die Nutzungsweisen des MP3-Formats, aber auch die jeweiligen markt-spezifischen Kreditkartenangebote. In beiden Fällen führte die private Entwicklung zu einer – von vorneherein intendierten – öffentlichen Nutzung in Finanzmarktpublika wie in Hörgemeinschaften, bei der entscheidende soziotechnische und ökonomische Bereiche für Nutzer*innen eine black box bleiben.

Im Falle des World Wide Webs – und auch anderen auf wissenschaftlichen Werten beruhenden Open-Source-Kulturen – ist diese Entwicklung merklich anders verlaufen. Auf primär öffentlich erfolgende Entwicklungen und Nutzungen folgte privatwirtschaftliche Zweckentfremdung. Je stärker öffentlich Entwicklung und Standardisierung erfolgen, umso wahrscheinlicher ist in der jüngeren Geschichte digitaler Medien ihre Umnutzung durch Dritte geworden. Man muss diesen Wechseln in den Standardisierungskulturen illusionslos und agnostisch beschreiben, denn der Status des Webs, aber auch der Wikipedia-Kultur als Utopie freien, gemeinwohlorientierten Wissens ist längst ein historisches Residuum. Je genauer die Rekonstruktion von offenen Standards erfolgt, umso mehr verschiebt sich die Perspektive auf deren strategische Rolle in neuen Medienindustrien und industriellen Mediatisierungen.

So hat etwa die Wirtschaftshistorikerin JoAnne Yates durch ethnografische Feldforschung zeigen können, wie in der offenen Standardisierungskultur des World-Wide-Web-Konsortiums industrielle Interessen vor gemeinwohlorientierte und wissenschaftliche Aspekte gerückt sind.[11] Die Innovationsforscherin Barbara van Schewick hatte bereits 2010 diagnostiziert, wie insbesondere Google durch den strategischen Einsatz von Open Source die skills und Arbeitszeit von Entwickler*innen zugunsten ökonomischer und technischer Hegemonie zum Teil des eigenen Ökosystems macht.[12] Auf die Universalisierung des öffentlichen Webs zwischen 1995 und 2005 folgte offenbar eine Modularisierung, auf der unsere digitale Jetztzeit mit ihren datengetriebenen Plattformökonomien beruht. Je öffentlicher die Standardisierung stattfindet – etwa in der Internet Engineering Taskforce, dem World Wide Web Consortium, offenen Wissenskulturen und Open-Source-Communities –, umso weiter das Spektrum der spezialisierten Anwendungen, die die neue Technik mit hervorbringen und zugleich parasitär kapern. Das Web 2.0 war das kommerzielle Einfallstor dieser Industrialisierung, weil es das Web aus seiner anfänglichen Sprachorientierung herauslöste – zugunsten der Programmierbarkeit immer neuer verfolgbarer Datenaustäusche und, sukzessive, Mustererkennungen. Datenpraktiken überlagern Medienpraktiken, indem sie sie unterwandern.

Zwar konstituieren sich computing wie networking weiterhin in und durch Praxisgemeinschaften und ihre Grenzobjekte. Deren Bedingung liegt jedoch weniger in der wissenschaftlichen und zivilgesellschaftlichen Selbstorganisation, als in den neuen digitalen Medienagenturen und -industrien. Diese mögen zunächst multipel verteilt erscheinen, manifestieren sich aber durch die Marktausschaltungen eines neuen datenindustriellen Komplexes. „How the computer became universal“ lautet zurecht der Untertitel von Paul Ceruzzis und Thomas Haighs kommender New Modern History of Computing.[13] Aber nachdem der Computer praktisch universal geworden ist, steht seine proteische Natur nur noch wenigen Akteur*innen wirklich offen. In digitalen Formaten, Modulen und Standards manifestiert sich derjenige Effekt, den Harold Innis bias of communication genannt hat.[14] Wenn die vernetzten Rechner trotzdem überall und nirgends zu sein scheinen, wird es Zeit für eine neue, kritische Agenturtheorie der digitalen Medien. Fabelhafte Wolken und ihre Datenpraktiken dürfen nicht im medienökologischen Ungefähr verbleiben, sondern müssen durch ihre Produktions- und Machteffekte resituiert werden.

Die Universalisierung von Techniken als Medien bleibt ein sozial gestaltbarer Prozess. Man kann nicht nur, sondern man muss sich weiterhin andere Welten des kooperativen Rechnens vorstellen. Die einstmals universelle Maschine bleibt medientheoretisch durch ihre Spezialisierungen zurückzuerobern, nachdem andere sie gekapert haben. Es sind nicht zuletzt die Wissenschaften, in denen neue Formen des Computer-Supported Cooperative Research fortwährend erfunden werden. Es gibt diese Welten eines anderen kooperativen Rechnens und Vernetzens also schon und immer noch – überall da, wo Erhard Schüttpelz’ Medientheorie wirkt.

Herzlichen Glückwunsch zum nunmehr 61. Geburtstag, lieber Erhard!

*** crossposting from boasblog: universalism by detours, first pre-published on February 23, 2021 ***

Literatur

[1] Michel Serres, „Vorwort“, in Elemente einer Geschichte der Wissenschaften, hg. von Michel Serres, stw 1355 (Frankfurt am Main: Suhrkamp, 1994), 11–37, hier S. 35.

[2] Serres, S. 35.

[3] Pierre Lévy, „Die Erfindung des Computers“, in Elemente einer Geschichte der Wissenschaften, hg. von Michel Serres, stw 1355 (Frankfurt am Main: Suhrkamp, 1998), 905–944, hier S. 918f.

[4] Lévy, S. 922.

[5] David Gugerli, Wie die Welt in den Computer kam. Zur Entstehung digitaler Wirklichkeit (Frankfurt am Main: Fischer, 2018).

[6] Susan Leigh Star, Hrsg., The Cultures of Computing (Oxford; Cambridge, MA: Blackwell, 1995).

[7] ANSI, „ANSI X4.13–1971. American National Standard Specifications for Credit Cards“ (New York: American National Standards Institute, 28. April 1971), S. 7.

[8] Noortje Marres und David Stark, „Put to the Test: For a New Sociology of Testing“, The British Journal of Sociology 71, Nr. 3 (1. Juni 2020): 423–443, https://doi.org/10.1111/1468-4446.12746, S. 434.

[9] Jonathan Sterne, MP3. The Meaning of a Format, Sign Storage Transmission (Durham; London: Duke University Press, 2012), S. 153.

[10] Sterne, S. 182.

[11] JoAnne Yates und Craig Murphy, Engineering Rules. Global Standard Setting Since 1880, Hagley Library Studies in Business, Technology, and Politics (Baltimore: Johns Hopkins University Press, 2019), S. 269f.

[12] Barbara van Schewick, Internet Architecture and Innovation (Cambridge, MA; London: MIT Press, 2010), S. 389f.

[13] Thomas Haigh und Paul E. Ceruzzi, A New History of Modern Computing. How the Computer Became Universal, History of Computing (Cambridge, MA; London: MIT Press, 2021).

[14] Harold A. Innis, Kreuzwege der Kommunikation. Ausgewählte Texte, hg. von Karlheinz Barck, Ästhetik und Naturwissenschaften, Medienkultur (Wien; New York: Springer, 1997), S. 95f.